Une analyse des résultats de l’enquête Toluna / Harris Interactive par Farah BENCHELIHA et Bathscheba MACE, avocates expertes du numérique

L’intelligence artificielle n’est plus une curiosité technologique ni un horizon lointain. Elle s’est imposée au cœur de notre quotidien, s’infiltrant dans nos usages, nos échanges et dans le débat public à l’échelle nationale, européenne et mondiale. Pourtant, pour beaucoup, l’IA demeure une technologie ambivalente : fascinante, prometteuse, mais aussi inquiétante, tant ses contours restent flous pour chacun d’entre nous. L’enquête menée par Toluna et Harris Interactive en mai 2025 auprès d’un panel de 1025 français, de tous les genres, âges et catégories socioprofessionnelles le met en évidence.

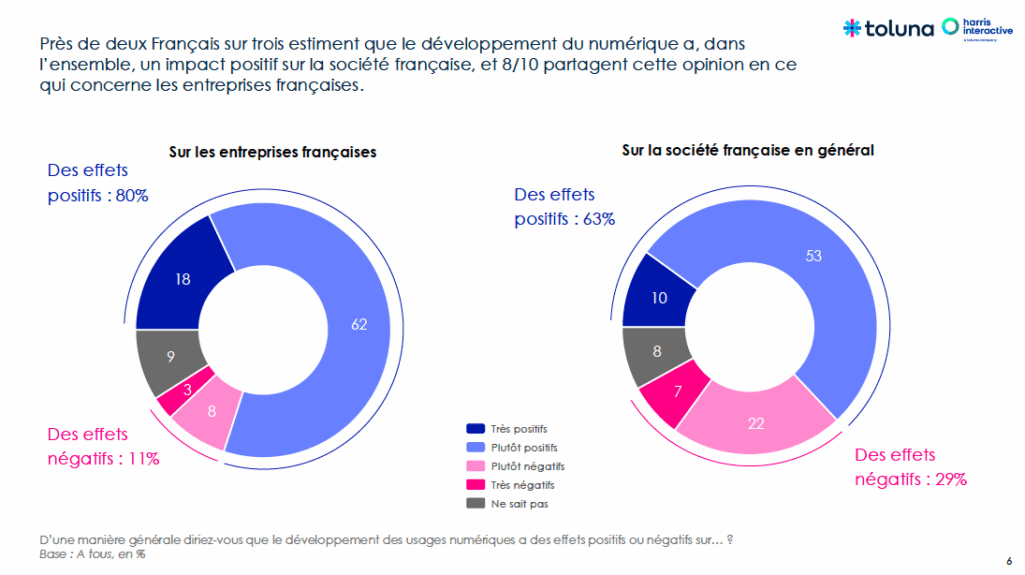

Le numérique continue d’être perçu comme un vecteur de modernisation : 80 % des Français considèrent qu’il a un impact positif sur les entreprises et 63 % sur la société dans son ensemble. Les usages sont connus, les bénéfices visibles, les risques globalement identifiés.

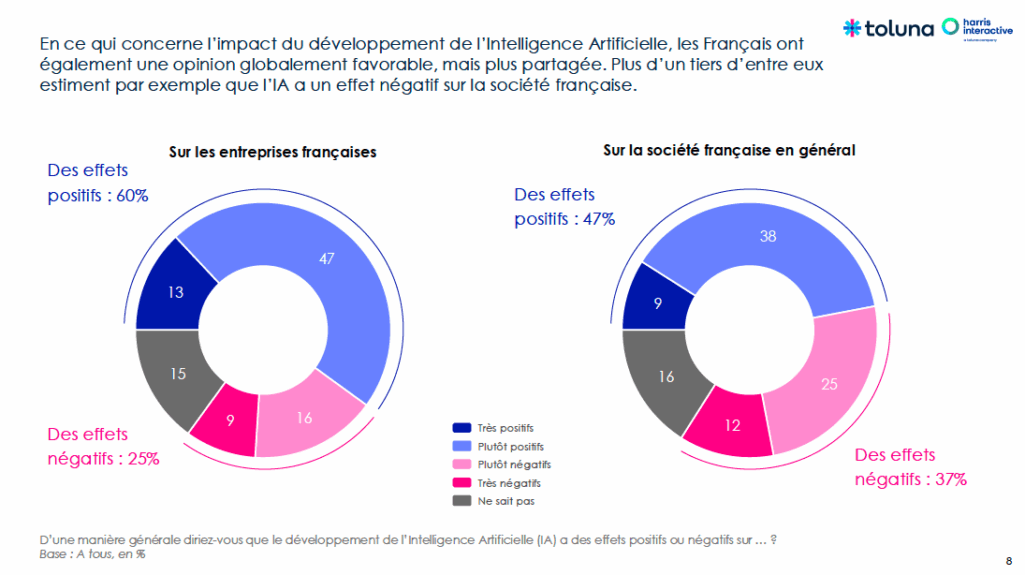

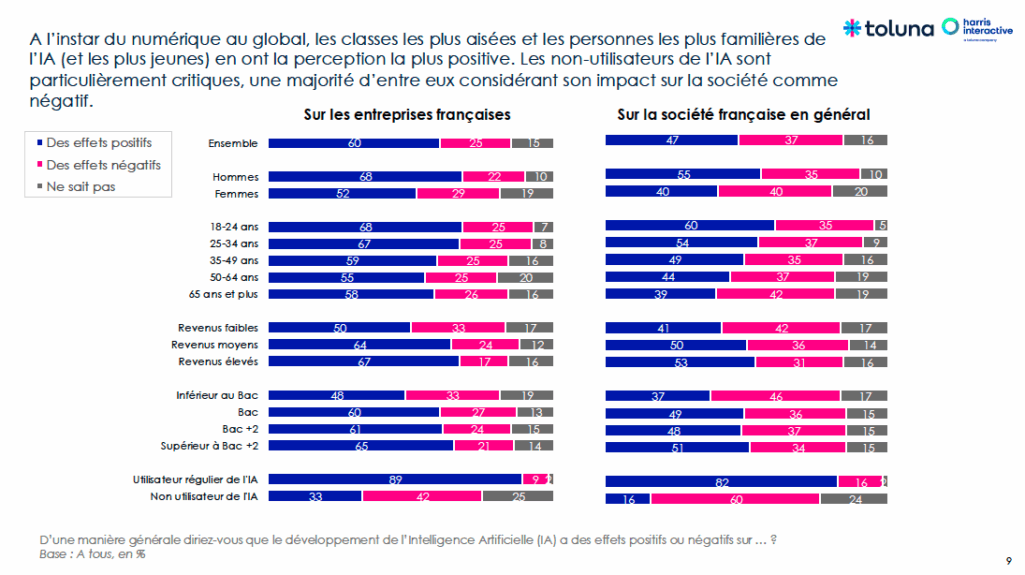

Pour l’IA, l’appréciation est plus réservée. Certes, 60 % des répondants estiment qu’elle est susceptible d’avoir des effets positifs pour les entreprises, mais ce pourcentage tombe à 47 % lorsqu’il s’agit de projeter ses éventuels effets positifs sur la société. La technologie en elle-même ne semble pas rejetée : elle invite à la mesure, à la prudence et, peut-être, à l’hésitation.

Car s’agissant de l’IA, la part des indécis est nettement plus élevée que pour le numérique : 1 français sur 7 ne parvient pas à avoir une opinion tranchée sur les effets de l’IA sur nos vies. Cette indécision ne traduit pas seulement une hésitation, mais une difficulté de projection et, sans doute, d’appropriation.

Une fracture avant tout cognitive

L’étude permet de dépasser l’opposition simpliste entre “technophobes” et “technophiles”. Elle montre que la fracture n’est ni purement générationnelle ni strictement socio-économique, elle est d’abord cognitive.

Les répondants les moins diplômées projettent sur l’IA davantage de risques, notamment en matière de remplacement des emplois et d’effets sociétaux indésirables. Un second clivage tient à l’usage. Parmi les utilisateurs réguliers, 89 % jugent l’IA positive pour les entreprises et 82 % pour la société. À l’inverse, chez les non-utilisateurs, seuls 42 % considèrent l’IA comme positive pour les entreprises, et 60 % estiment qu’elle a un effet négatif sur la société.

Autrement dit : l’usage nourrit la compréhension, son absence nourrit la crainte.

Santé, sécurité, recherche et innovation : les opportunités identifiées

Les Français, dans leur majorité, identifient clairement les domaines où technologies numériques et IA sont porteuses de progrès et d’opportunités.

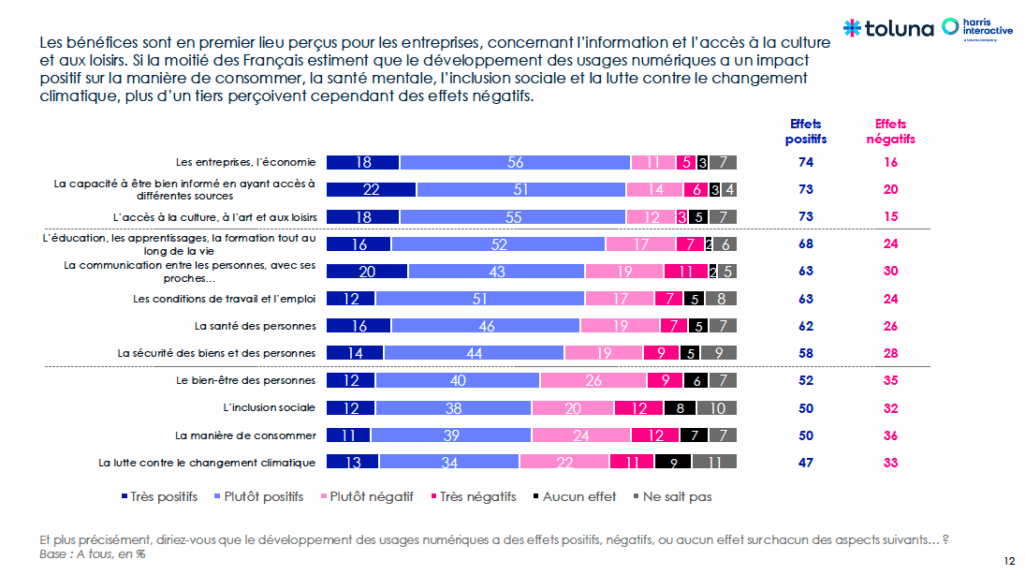

Pour le numérique, les effets positifs sont largement reconnus pour les entreprises et l’économie (74 % d’opinions positives pour 16 % de négatives), la capacité à être bien informé (73 % contre 20 %), l’accès à la culture, à l’art et aux loisirs (73 % contre 15 %) et l’éducation, l’apprentissage et la formation (68 % contre 24 %).

Les réserves existent, mais se concentrent sur des sujets plus sensibles : l’inclusion (50 % d’avis positifs contre 32 % négatifs), les modes de consommation (50 % contre 36 %), et, surtout, la lutte contre le changement climatique, pour laquelle seuls 47 % des répondants jugent l’impact du numérique positif, contre 33 % qui l’estiment négatif.

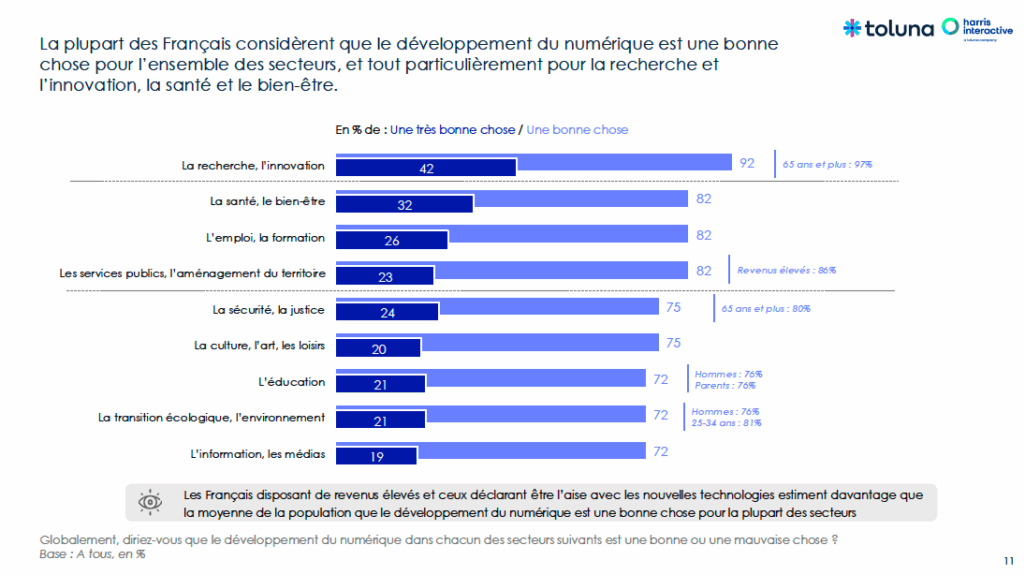

Les opportunités sont massivement relevées : 92 % des répondants évoquent la recherche et l’innovation, 82 % la santé et le bien-être, 82 % pour l’emploi et la formation.

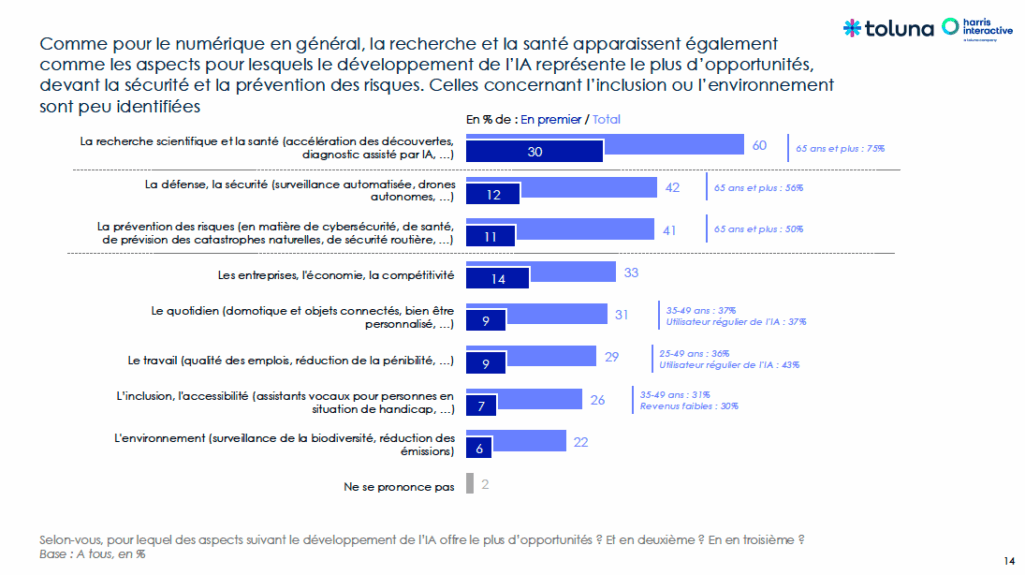

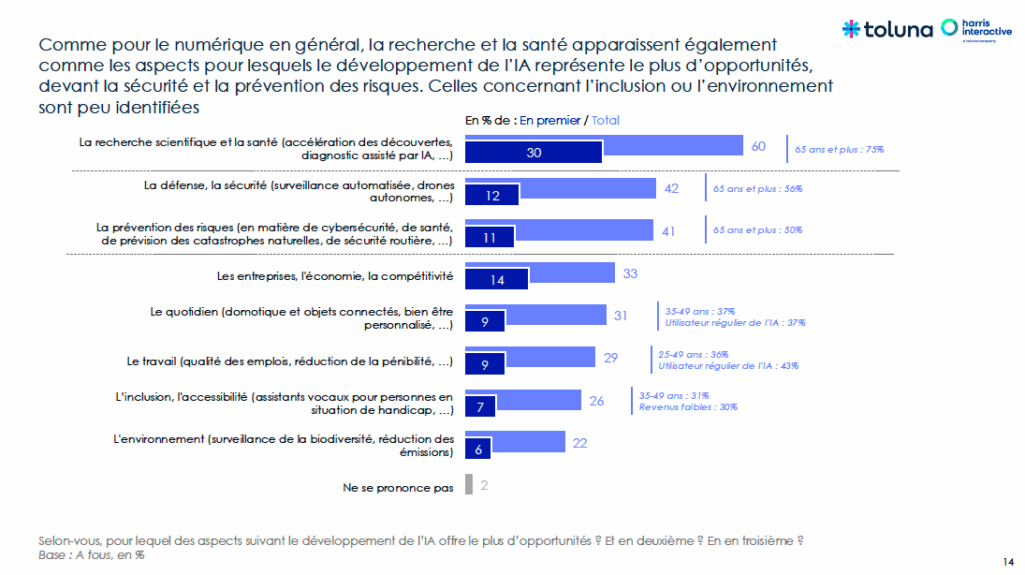

Pour l’IA, la perception, bien que positive, est plus timide. Les opportunités les plus spontanément identifiées sont la santé et la recherche médicale (60 %), la défense et la sécurité (42 %) et la prévention des risques – cybersécurité, santé, catastrophes naturelles, sécurité routière (41 %). A l’inverse, peu d’opportunités sont relevées concernant le travail (29 %), l’inclusion et de l’accessibilité (26 %) ou l’environnement (22 %).

La santé concentre la confiance, tandis que l’emploi et l’écologie concentrent les doutes. Ce scepticisme n’est pas surprenant au vu de l’empreinte écologique des systèmes d’IA, les modèles les plus avancés étant extrêmement énergivores. L’IA semble donc perçue comme un outil de progrès qui doit soigner, sous réserve de ne fragiliser ni les équilibres environnementaux ni la cohésion sociale.

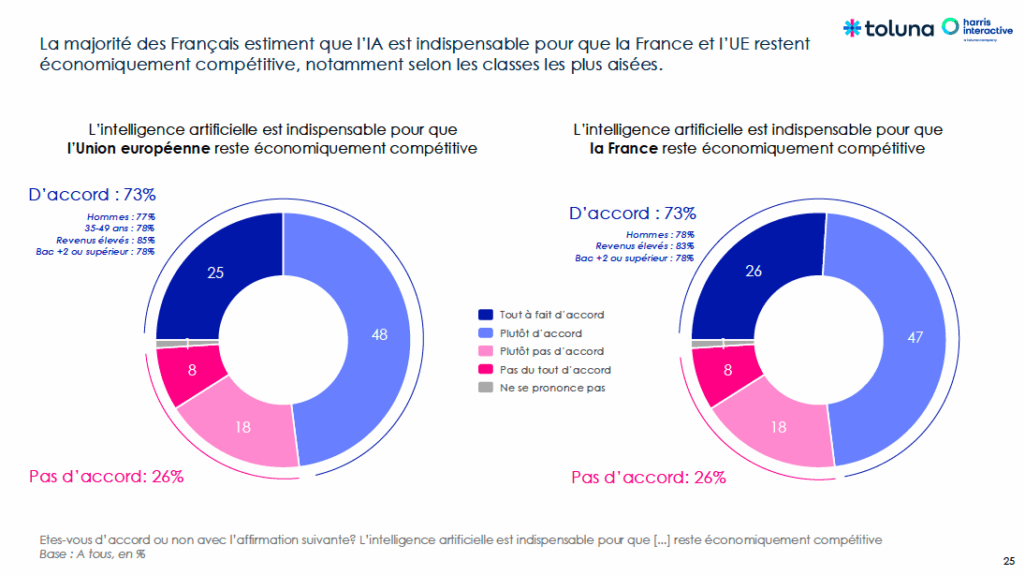

Pourtant, elle n’est pas perçue comme accessoire : 73 % des Français estiment qu’elle est essentielle pour la compétitivité économique de la France et de l’Union européenne.

On sait donc que l’IA sera un pilier industriel, mais on ignore encore si elle sera un pilier social.

Un besoin de formation exprimé de manière unanime

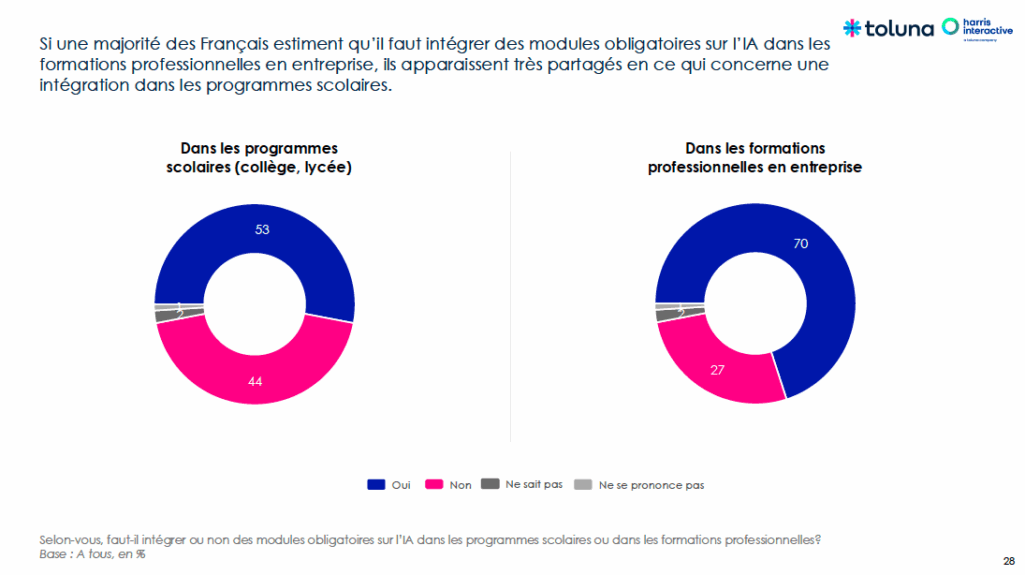

Le constat est unanime : les Français veulent comprendre l’IA. 70 % des répondants souhaitent l’intégration de modules IA dans la formation professionnelle et 53 % estiment qu’elle devrait être enseignée dès l’école.

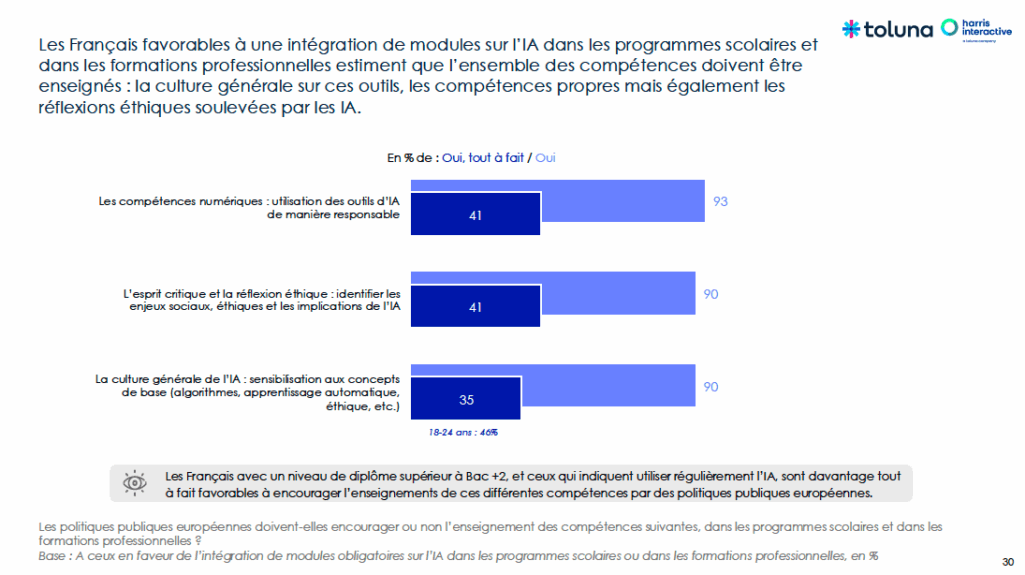

Lorsqu’on interroge les citoyens sur les compétences que les politiques publiques européennes devraient encourager, le consensus est encore plus net : 93 % pour l’usage responsable, 90 % pour la réflexion éthique et l’esprit critique, 90 % pour une culture générale de l’IA, 72 % pour les compétences numériques de base.

Ces chiffres dessinent une attente claire : les citoyens français ne réclament pas une sensibilisation, mais une véritable formation développant la capacité de comprendre l’IA, de situer son fonctionnement, ses effets et ses limites.

Le Règlement européen sur l’intelligence artificielle répond en partie à cette attente (ou « AI Act »). Son article 4 impose aux organisations qui développent ou déploient des systèmes d’IA de veiller « dans la mesure du possible » à ce que les personnes chargées de les concevoir, de les utiliser ou de les superviser disposent « d’un niveau suffisant de connaissances en matière d’IA », adapté à leurs fonctions [1]. Des actions d’« alphabétisation » à l’IA, et donc de formations ciblées, doivent être initiées par les entités qui y recourent. Mais la formulation attenue la portée de l’obligation et cette dernière semble concerner les usages professionnels, exclusivement.

Bien que cet article constitue un point de départ important, il ne proclame aucun droit universel à la formation pour le grand public.

L’AI Act impose également une obligation de documentation dont la granularité dépend du niveau de risque : informations minimales pour les systèmes d’IA générale (capacités, limites, données d’entrainements) [2], documentation plus détaillée pour les systèmes à haut risque (architecture, performances, supervision humaine, limites et incertitudes) [3].

Sans formation, la transparence reste théorique : elle crée surtout l’illusion de la maîtrise.

Transférer la responsabilité de comprendre aux seules organisations ou aux seuls individus revient à laisser s’installer un décalage qui n’est plus seulement technique mais potentiellement, sociétal. Ce décalage a été analysé sous des angles différents par deux auteurs souvent mobilisés dans les débats technologiques. Günther Anders décrivait ce qu’il appelait la « disproportion prométhéenne » : la technique progresse à une échelle et dans des environnements que l’imagination humaine peine à suivre [4]. Kurzweil, lui, insistait sur une autre dynamique : notre intuition reste linéaire alors même que les technologies évoluent de façon exponentielle [5].

Ces analyses convergent sur un point : lorsque la compréhension n’avance pas au même rythme que la technique, la capacité de maîtriser les usages s’amenuise. La connaissance devient alors un élément de régulation à part entière.

C’est précisément pour éviter ce glissement que la formation doit être pensée comme un levier de maîtrise collective et non comme une simple faculté individuelle.

Sur ce point, l’Union européenne commence à structurer une réponse plus large. Le 9 avril 2025, la Commission a présenté son plan d’action pour faire de l’Europe « le continent de l’IA » [6].

Ce plan s’articule autour de plusieurs initiatives :

– l’Académie européenne des compétences en IA, destinée à offrir des programmes de formation et de reconversion ;

– l’augmentation de l’offre de licences, masters et doctorats spécialisés en IA dans l’Union ;

– des programmes de bourses et de « retour » pour retenir ou faire revenir les talents européens ;

– des actions de sensibilisation à l’IA dans les écoles, financées via les pôles européens d’innovation numérique.

Du côté de la France, la Stratégie Nationale pour l’Intelligence Artificielle (SNIA), lancée en 2018 intégrée dans le plan France 2030, ambitionne de former massivement les Français à l’IA, avec un objectif de 15 millions de personnes formées d’ici 2030 et la création de neuf pôles d’excellence nationaux (« IA Clusters ») [7]. Près de 2,5 milliards d’euros sont mobilisés pour la formation aux métiers de l’IA, dont 560 millions dédiés au soutien et à la diversification des établissements d’excellence. Cette offre de formation couvre tous les niveaux (initiale, alternance, continue) afin d’accompagner la montée en compétence du pays et favoriser son positionnement parmi les leaders européens.

Mais la plupart de ces initiatives sont encore en phase de déploiement. Leur effet concret sur la population, et en particulier sur les publics les plus éloignés du numérique, reste pour l’heure difficile à mesurer.

Dès lors, une interrogation apparaît : ces efforts permettront-ils réellement de réduire la fracture cognitive mise en lumière par l’enquête ?

Former pour comprendre les usages et les impacts

Ce besoin exprimé par les répondants a une résonance particulière dans un domaine où la confiance envers l’IA est paradoxalement l’une des plus élevées : la sécurité. Selon l’enquête Toluna, 42 % des Français estiment que l’IA peut renforcer la défense ou la prévention des risques.

Dans un contexte de tensions géopolitiques, de cybermenaces et d’insécurité, cette préoccupation n’a rien de surprenant. La recherche de sécurité est un besoin naturel et une zone de vulnérabilité. La philosophie politique l’a largement montré : Rousseau rappelle que l’être humain « naît faible et a besoin de protection » [8]. Et Arendt a montré combien les dispositifs créés pour sécuriser peuvent devenir les instruments d’une surveillance installée au nom de la nécessité, par une succession de renoncements presque imperceptibles [9]. L’IA qui protège peut aussi devenir celle qui surveille, surtout si ses mécanismes sont insaisissables.

Le projet européen « Chat Control » en a fourni une illustration saisissante. Présenté comme un outil de lutte contre l’exploitation sexuelle des mineurs – objectif évidemment incontestable – il reposait, en 2022, sur une analyse systématique et automatisée des communications privées, y compris chiffrées. De nombreux observateurs et États membres ont objecté que ce projet fragilisait les fondements mêmes d’une approche proportionnée de la sécurité. Si le projet a été abandonné en l’état, c’est précisément parce qu’il a suscité une large controverse, notamment sur les réseaux sociaux, à l’été 2025 [10].

Cet épisode met en lumière la nécessité que les citoyens disposent des clés de compréhension d’un dispositif (et de la technologie sur laquelle il s’appuie) pour consentir – ou s’opposer – à son déploiement.

A cet égard, les interdictions prévues par l’AI Act comportent des gardes fous, notamment l’interdiction du scoring social, de la manipulation cognitive des populations vulnérables ou encore de l’identification biométrique en temps réel [11]. Mais le texte révèle également ses limites. Il revient d’abord aux acteurs eux-mêmes de classifier leur IA, suivant les critères qu’il fixe. Il suppose ensuite de compter largement sur les autorités de contrôle pour détecter les non-conformités alors-même qu’elles ont, par nature, besoin d’un relais citoyen.

C’est précisément pour cette raison que la formation devient un indispensable.

Un cadre européen attendu

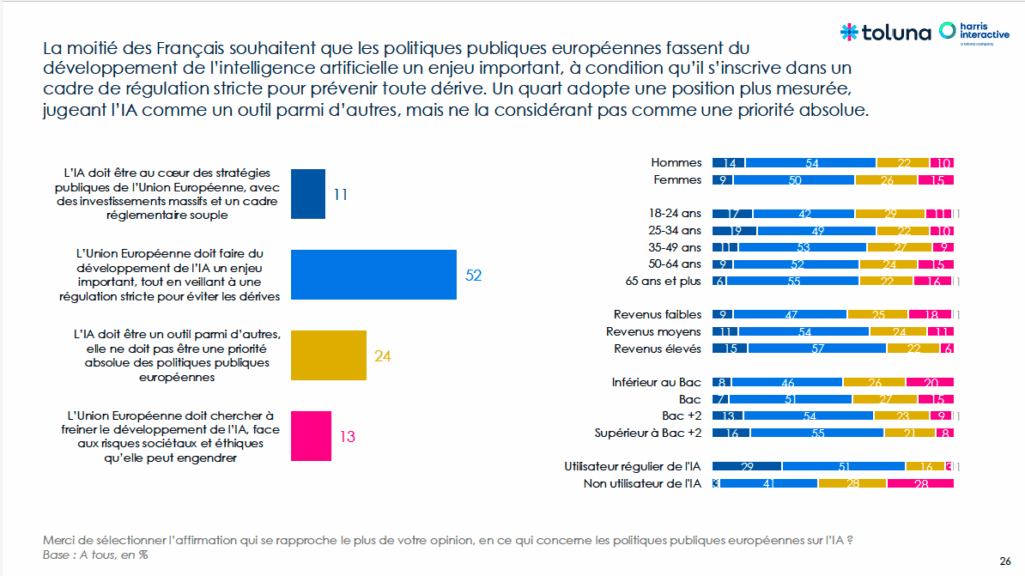

L’enquête montre que 52 % des répondants considèrent le développement de l’IA comme un enjeu majeur pour l’Union européenne, à condition qu’il soit accompagné d’une régulation stricte pour éviter les dérives.

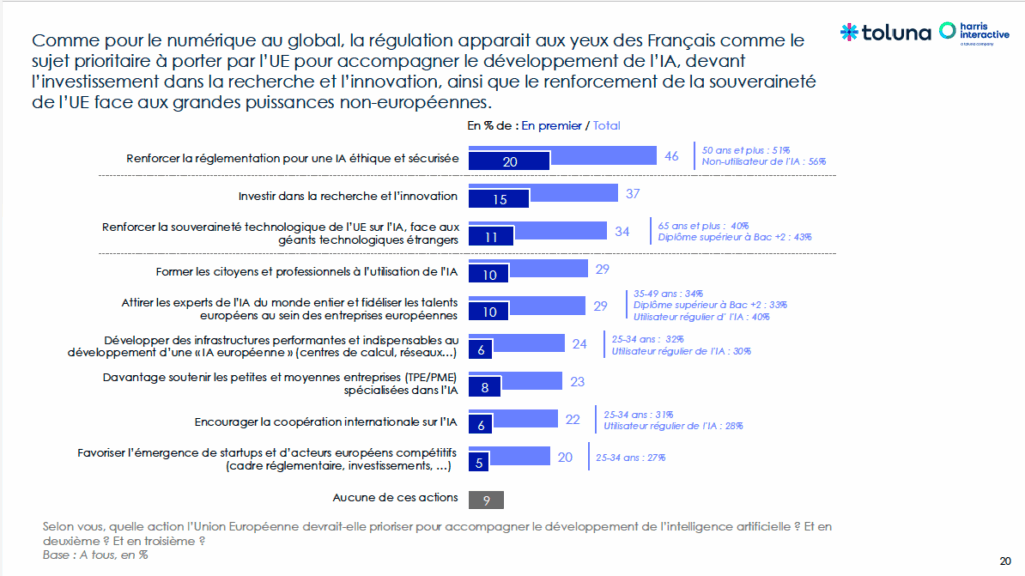

Les priorités exprimées le confirment : près d’un répondant sur deux attend de l’Europe qu’elle garantisse une IA éthique et sécurisée au moyen de la règlementation.

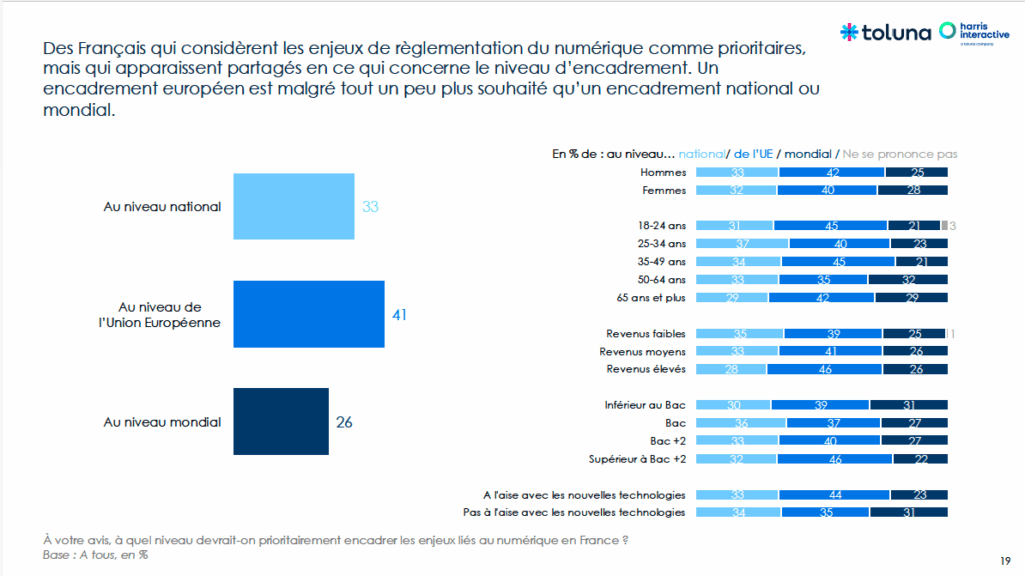

En complément, 41 % des répondants estiment que l’échelon européen est le plus pertinent pour encadrer l’IA, loin devant l’échelon national (33 %) ou mondial (26 %).

Cette confiance dans l’échelon européen s’explique aisément. Dans un espace numérique transfrontières, les règlementations strictement nationales apparaissent fragmentées et inégales. L’Union a déjà démontré sa capacité à produire des cadres juridiques structurants dans le domaine numérique, à commencer par le RGPD.

Mais une question demeure : les citoyens savent-ils qu’un premier cadre existe déjà ?

Rien n’est moins certain. Si le RGPD bénéficie d’une certaine notoriété, l’AI Act, adopté en 2024, est encore très peu médiatisé en dehors des cercles spécialisés, d’autant que plusieurs de ses dispositions entreront progressivement en application jusqu’en 2027.

Pour une politique européenne de formation tout au long de la vie

L’étude montre que l’IA est acceptée, parfois même attendue, mais sous la condition du déploiement corolaire d’un environnement de confiance. Or la confiance ne se décrète pas : elle se construit.

Dans La fin de l’individu, Gaspard Koenig souligne que l’IA peut progressivement réduire les marges de manœuvre en orientant les choix, en anticipant les comportements et en rendant les alternatives moins visibles. Or sans choix réel, il ne peut y avoir de liberté. Et sans liberté, la responsabilité individuelle cesse d’exister car elle suppose une capacité de décision éclairée [12].

Cette analyse rejoint les préoccupations des Français interrogés. L’Union a engagé plusieurs initiatives en matière de formation (voir ci-avant). Ces dispositifs témoignent d’un mouvement réel, mais n’ont pas encore été entièrement déployés. En tout état de cause, ils ne consacrent pas un droit effectif à la formation, accessible et garanti pour chacun.

Or les résultats de l’étude confirment une attente plus forte : les effets positifs perçus de l’IA sont faibles sur plusieurs thématiques sensibles – inclusion, environnement, travail – et ce sont précisément celles où les répondants expriment un besoin marqué d’accompagnement. Sans droit à la formation, la fracture cognitive peut devenir une fracture sociétale. Sans encadrement lisible, la régulation reste une promesse abstraite. Sans compréhension minimale, la liberté de choix reste théorique.

Dès lors, la responsabilité collective devient la condition même de la responsabilité individuelle.

Une compréhension partagée protège.

Parce qu’une société qui comprend est une société qui choisit.

Là où une société qui ignore finit, tôt ou tard, par cesser de décider.

[1] Règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 (AI Act), art.4.[2] Ibid, AI Act, art. 53.

[3] Ibid, AI Act, art. 11.

[4] Günther Anders, L’Obsolescence de l’homme. Sur l’âme à l’époque de la deuxième révolution industrielle, trad. fr. Christophe David, Éditions Fario, 2002 (éd. orig. 1956).

[5] Ray Kurzweil, The Age of Spiritual Machines : When computers Excee Human Intelligence, Penguin Publishing group, 2000.

[6] AI Continent Action Plan, COM(2025) 165 final, 9 avril 2025 : The AI Continent Action Plan [7] Direction générale des entreprises, La stratégie nationale pour l’intelligence artificielle, 12 fév. 2025 : France 2030 : stratégie nationale pour l’intelligence artificielle

[8] Jean-Jacques Rousseau, Du contrat social, 1762, Livre I.

[9] Hannah Arendt, The Origins of Totalitarianism, Harcourt, 1951.

[10] Proposition de règlement du parlement européen et du conseil établissant des règles en vue de prévenir et de combattre les abus sexuels sur enfants, n° 2022/0155, du 11 mai 2022 ; Voir également : Le Monde, « Chat Control » : le projet européen de surveillance des messageries largement abandonné, 31 oct. 2025 : « Chat Control » : le projet européen de surveillance des messageries largement abandonné

[11] Ibid, AI Act, art. 5.

[12] Gaspard Koenig, La fin de l’individu – Voyage d’un philosophe au pays de l’IA, L’Observatoire, 2019.